Поняття інформації відноситься до основних понять науки і тісно пов'язане з такими поняттями, як «інформаційні ресурси», «інформаційні технології», «інформаційне забезпечення», «інформаційні системи», «інформаційні структури» тощо. Для того, щоб дати найбільш повне визначення інформації, необхідно звернути увагу на те, що в її основі лежить взаємозалежність пари об'єктів – джерела і споживача інформації. Джерелами інформації, насамперед, є природні об'єкти: люди, тварини, рослини, планети та ін. Разом із цим в міру розвитку науки і техніки джерелами інформації стають наукові експерименти, машини, апарати, технологічні процеси. Значний також перелік об'єктів, що є споживачами інформації: люди, тварини, рослини, різноманітні технічні пристрої тощо.

Виходячи зі сказаного, дають таке означення інформації: інформація – «сукупність відомостей про всілякі об'єкти, явища, процеси». Більш змістовним є твердження: інформація є вибір одного варіанта (або декількох) із багатьох можливих і рівноправних. Слово «рівноправних» означає, що усі варіанти, із яких робиться вибір, мають щось спільне, тобто належать одній множині. У наукових працях розглянуто три основних варіанти вказаного вибору: якщо вибір підказаний (або вказаний), то мова йде про одержання (рецепцію) інформації; якщо вибір зроблений самостійно і випадково, то говорять про виникнення інформації; і, нарешті, якщо вибір однозначно визначений ситуацією або попередніми подіями (тобто вибору, по суті, немає), то про інформацію взагалі говорити не доводиться.

Основними формами подання інформації є символьна, текстова і графічна.

Символьна форма ґрунтується на використанні символів – літер, цифр, знаків і т. д., є найбільш простою і практично застосовується тільки для передачі сигналів про різні події.

Більш складною є текстова форма подання інформації. Тут, як і в попередній формі, використовуються символи – літери, цифри, математичні знаки. Однак інформація закладена не тільки в цих символах, але й у їх сполученні, порядку проходження. Завдяки взаємозв'язку символів і відображенню мови людини текстова інформація надзвичайно зручна і широко використовується в повсякденному житті.

Найбільш місткою, але і найбільш складною, є графічна форма подання інформації. Образи природи, фотографії, креслення, схеми, малюнки мають велике значення в нашому житті і містять величезну кількість інформації. І хоча інформація не має ні маси, ні геометричних розмірів, жодних фізичних або хімічних властивостей, проте для її існування обов'язкова наявність якогось матеріального об'єкта, що передає або зберігає інформацію. Таких об'єктів досить багато, і їхня кількість увесь час зростає.

Можливі різні класифікації за різними ознаками. Як приклад можна навести одну з класифікацій соціальної інформації, згідно з якою виділяються два основних класи – масова (загальна) і спеціальна (системна) інформація.

Масова інформація – соціальна інформація, адресована всім членам суспільства незалежно від їх становища і роду занять.

Спеціальна інформація адресована не всім членам суспільства, а певним соціальним групам (наприклад, ученим даного фаху, економістам, робітникам якоїсь професії і т. д.). Для сприйняття цієї інформації необхідний початковий запас спеціальних знань і володіння професійною мовою. Назвемо деякі найбільш важливі різновиди спеціальної соціальної інформації.

1. Наукова інформація – утворюється в результаті науково-дослідної діяльності. Наукову інформацію можна визначити як передане в інформаційному процесі наукове знання.

2. Технічна інформація – створюється в сфері техніки і призначена для вирішення технічних задач (розробки нових технічних пристроїв, машин, матеріалів і т. п.). Структура і властивості наукової і технічної інформації дуже близькі, тому ці два види часто об'єднують терміном «науково-технічна інформація».

3. Технологічна інформація – безпосередньо використовується в сфері матеріального виробництва для створення матеріальних благ (продуктів харчування, одягу, машин тощо).

4. Планово-економічна інформація – наприклад, про стан і перспективи розвитку промислових підприємств – використовується для планування і керування виробництвом.

Кожне повідомлення містить як умовну, так і безумовну інформацію. Визначити, яка інформація є умовною і яка безумовною, не так просто, як це здається на перший погляд.

Тут відіграють роль такі обставини:

- по-перше, умовна інформація має тенденцію до уніфікації, що природно, оскільки цінність її при цьому зростає;

- по-друге, уніфікована умовна інформація часто сприймається як безумовна;

- по-третє, найбільш цікавим і гострим залишається питання про умовність (або безумовність) інформації в природничих науках; прийнято вважати, що, вивчаючи природу, ми одержуємо (рецепіюємо) об'єктивну (тобто безумовну) інформацію.

Відомі дві основних форми існування інформації – статична (у вигляді записів на папері, стрічці, диску, фотопапері тощо) та динамічна – під час її передавання. Потрібно зауважити, що процес фізичного перевезення чи пересування носія інформації (листа, магнітної стрічки, диска, касети тощо) не відноситься до динамічної форми існування інформації. Якщо дані передаються каналом зв’язку, то у кожній точці каналу під час передавання процес змінюється в часі і так само змінюється вплив зовнішніх факторів на сигнали, що несуть в собі інформацію. При фізичному перевезенні цього не відбувається, хоча дані, що зафіксовані на носію, теж підпадають під вплив зовнішніх факторів і можуть руйнуватися з часом. Таким чином, статичною цю форму можна назвати відносно. Більш точне визначення – квазістатична.

Інформація, що зберігається на носію, може зчитуватись, передаватись, знов записуватись, тобто вона може багаторазово переходити з однієї форми існування до іншої.

Основна проблема – передавання інформації з найменшими втратами. При цьому необхідно оцінювати інформацію кількісно.

2.1 Інформація та її характеристики

Перша спроба ввести науково обґрунтовану міру інформації була зроблена в 1927 році Р. Хартлі (Англія). Він запропонував та обґрунтував кількісну міру, яка дозволяє порівнювати спроможність різних систем передавати інформацію. Ця міра підходить і для систем зберігання інформації, тому вона є відправною точкою для створення теорії інформації.

Природною вимогою, що висувається до інформаційної міри, є вимога адитивності, тобто, кількість інформації, яка може бути збережена у двох однакових комірках, повинна бути удвічі більшою за ту, що зберігається в одній з них.

Якщо одна комірка для зберігання інформації має m можливих станів, то дві таких комірки будуть мати m2 можливих станів, а n однакових комірок – mn можливих станів. Це саме стосується і кількості можливих повідомлень. Якщо символ може прийняти значення «0» або «1», то з одного символу можуть бути одержані 2 повідомлення, з двох символів – 4, з трьох – 8 тощо. Таким чином кількість можливих повідомлень визначається кількістю символів, що входять до слова n та кількістю можливих станів символу m: mn. Тому Р. Хартлі ввів логарифмічну міру інформаційної ємності:

![]() .

.

Така міра задовольняє вимогу адитивності. Ємність засобу, що складається з n комірок і має mn станів, дорівнює ємності однієї комірки, помноженої на їх кількість:

![]() .

.

За одиницю вимірювання інформаційної ємності вибрана двійкова одиниця – біт (binary digit – двійковий знак), що дорівнює ємності однієї комірки з двома можливими станами. Інформаційна ємність С у двійкових одиницях в загальному випадку визначається як:

![]() ,

,

де ka – коефіцієнт, що залежить від основи логарифму а.

При використанні для зберігання інформації десяткових комірок більш зручно користуватись десятковими логарифмами. В цьому випадку:

K10 = log 2 10 ≈ 3,32,

тобто, одна десяткова комірка за інформаційною ємністю дорівнює 3,32 двійковим. Одиниця вимірювання кількості інформації в цьому випадку – діт.

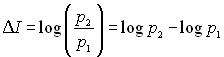

Якщо від джерела інформації каналом зв’язку передається повідомлення про подію, апріорна імовірність якої на передавальному боці дорівнювала p1, то після приймання повідомлення апостеріорна імовірність цієї події для приймача інформації дорівнює p2. Збільшення кількості інформації з урахуванням логарифмічної міри складає:

.

.

Для ідеального каналу зв’язку (без завад та спотворень) приймання інформації є вірогідною подією, тобто імовірність p2 дорівнює одиниці:

![]() . (2.1)

. (2.1)

Чим меншою буде імовірність p1, тим більшою буде невизначеність результату, тобто тим більша кількість інформації вміщується у прийнятому повідомленні.

Значення р1 знаходиться у межах 0 < р1 < 1, тобто ΔΙ завжди додатна величина. Якщо припустити, що може передаватися nа символів Sа, що відповідають події А, nb символів Sb, що відповідають події В тощо, а всього m різних символів. Символи Sа, Sb тощо являють собою алфавіт з різних m символів. Сума усіх символів q складає:

![]()

Згідно з (2.1) приймання символу Sа дає кількість інформації:

![]() ,

,

де pа – імовірність події А.

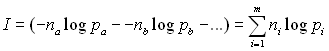

Тоді у nа символах міститься кількість інформації nа(- log pа). Загальна кількість інформації складає:

. (2.2)

. (2.2)

Вираз для визначення середньої кількості інформації, що припадає на один символ, можна отримати, розділивши (2.2) на q:

. (2.3)

. (2.3)

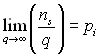

У (2.3) відношення ![]() є апріорною імовірністю появи символу Sа для великих значень nі та q,

є апріорною імовірністю появи символу Sа для великих значень nі та q, ![]() – імовірність символу Sb тощо.

– імовірність символу Sb тощо.

Тоді:

.

.

При цьому сума імовірностей: ![]() ,

,![]() оскільки одна з усіх m подій А, В, ... відбувається обов’язково (повна імовірність подій).

оскільки одна з усіх m подій А, В, ... відбувається обов’язково (повна імовірність подій).

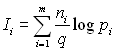

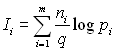

Таким чином, можна отримати вираз для середньої кількості інформації на один символ:

,

,

де pі – імовірність і-того символу.

Необхідно підняти вантаж на певний поверх 16-ти поверхового будинку (нумерація поверхів 0-15, N = 16). Скільки біт інформації повністю визначають завдання?

![]() .

.

Отже, 4 біти інформації необхідні й достатні для повного зняття невизначеності вибору. У цьому можна переконатися застосуванням логіки вирахування з послідовним розподілом навпіл інтервалів станів. Наприклад, для 9-го поверху:

1) вище 7-го поверху? Так = 1;

2) вище 11-го поверху? Ні = 0;

3) вище 9-го поверху? Ні = 0;

4) вище 8-го поверху? Так = 1.

Підсумок: поверх номер 9 або 1001 у двійковому численні, чотири двійкових розряди.

![]()

Якщо в наведеному прикладі на поверхах є по 4 квартири з нумерацією на кожному поверсі 0-3 (М=4), то при адресації вантажу у квартиру буде потрібно ще 2 біти інформації. Такий же результат одержимо, якщо замість незалежної нумерації поверхів і квартир на поверхах (два джерела невизначеності) ми будемо мати тільки наскрізну нумерацію квартир (одне узагальнене джерело):

![]() ,

,

тобто, кількість інформації відповідає вимозі адитивності: невизначеність об'єднаного джерела дорівнює сумі невизначеностей вихідних джерел, що відповідає інтуїтивній вимозі до інформації: вона повинна бути однозначною, а її кількість повинна бути тією самою незалежно від способу задання.